n8n, Dust ou AgentKit : le guide pour choisir votre plateforme d'agents IA

n8n, Dust ou AgentKit? Le guide 2025 pour choisir votre plateforme d'agents IA. Benchmark complet, scores, cas d'usage et recommandations par persona.

INTELLIGENCE ARTIFICIELLE

Iannis Iglesias

10/13/202538 min read

n8n, Dust ou AgentKit: quelle solution d'agents IA choisir?

Le marché des agents IA traverse un paradoxe fascinant. 78% des organisations déclarent utiliser l'intelligence artificielle dans au moins une fonction métier selon l'OCDE. Pourtant, seules 8% ont déployé des systèmes qualifiés de transformatifs. Entre ces deux chiffres se cache la différence entre expérimenter et produire de la valeur mesurable.

Ce décalage n'est pas qu'une question de maturité technologique. C'est un problème de choix d'infrastructure. Lancer un agent IA sur la mauvaise plateforme vous coûte rapidement entre 6 et 12 mois de temps perdu, des milliers d'euros dépensés et une équipe démobilisée par des outils qui ne tiennent pas leurs promesses.

Les plateformes d'agents IA se sont multipliées en 2025. Dust promet la gouvernance d'entreprise. n8n mise sur la flexibilité technique. AgentKit d'OpenAI vend la simplicité. Mais derrière les présentations marketing se cachent des différences architecturales fondamentales qui déterminent si votre projet aboutira ou rejoindra le cimetière des POCs zombies.

Cet article vous donne un benchmark factuel, des recommandations situées par profil d'entreprise et les signaux d'alerte qui indiquent qu'une plateforme ne convient pas à votre contexte. Vous saurez précisément quelle solution choisir selon que vous êtes un solopreneur technique, une start-up de 6 personnes ou une PME de 70 collaborateurs.

Nous avons volontairement écarté les suites enterprise comme Salesforce Agentforce, Microsoft Copilot ou Google Gemini Enterprise. Ces plateformes partagent trois caractéristiques qui les distinguent : un ticket d'entrée élevé (souvent 30 à 50€ par utilisateur et par mois minimum), un verrouillage fort à un écosystème propriétaire et une complexité d'infrastructure significative. Si vous êtes déjà engagé dans l'un de ces écosystèmes, ces solutions méritent considération. Sinon, les trois plateformes analysées ici offrent plus d'agilité et d'indépendance.

I. Avant de comparer : pourquoi ces trois plateformes IA ?

Le paysage des outils d'automatisation et d'agents IA compte des dizaines d'acteurs. Tous ne jouent pas dans la même catégorie.

Les acteurs écartés

Automatisation classique : Zapier, Make et IFTTT excellent pour automatiser des tâches répétitives entre applications. Mais ils ne sont pas conçus pour orchestrer des agents autonomes capables de raisonnement complexe, de gestion de contexte sur plusieurs étapes ou d'exploitation de bases de connaissances via RAG. Si votre besoin se limite à "quand un email est reçu, créer une tâche Notion", ces outils suffisent. Pour des agents qui analysent, décident et agissent de manière contextuelle, ils montrent leurs limites.

Suites enterprise : Microsoft Copilot Suite, Google Gemini Enterprise et AWS Bedrock + Amazon Q sont des plateformes puissantes. Mais elles partagent trois caractéristiques qui les distinguent des solutions que nous analysons : un ticket d'entrée élevé : au-delà des licences à 30$/user/mois, compter 10 à 50K€ minimum pour un POC fonctionnel une fois intégrés les services professionnels, les consultants certifiés et la formation obligatoire ; un verrouillage fort à un écosystème propriétaire (Microsoft 365, Google Workspace, AWS) et une complexité d'infrastructure significative. Si vous êtes déjà engagé dans l'un de ces écosystèmes, ces solutions sont intéressantes. Sinon, elles imposent des dépendances structurelles lourdes qui dépassent le cadre de cet article centré sur des plateformes plus agnostiques.

Les trois archétypes retenus

Nous avons sélectionné trois plateformes qui incarnent trois approches radicalement différentes de l'infrastructure d'agents IA :

Dust représente la plateforme de connaissance d'entreprise. Son positionnement : connecter vos données internes et vos outils externes via des agents gouvernés, avec la sécurité et la conformité au centre. Dust cible les organisations qui privilégient le déploiement rapide avec des garde-fous stricts.

n8n incarne le moteur d'automatisation extensible. Sa promesse : une flexibilité maximale via une approche visual-first qui ne sacrifie pas la puissance technique. n8n attire les équipes qui veulent le contrôle total de leur infrastructure et la capacité d'intégrer n'importe quel système.

OpenAI AgentKit se positionne comme le toolkit d'expérience utilisateur. Son pari : simplifier radicalement la création d'agents conversationnels en acceptant un verrouillage à l'écosystème OpenAI. AgentKit séduit ceux qui veulent prototyper en quelques heures plutôt qu'en quelques semaines.

Ces trois solutions couvrent le spectre des besoins réels : gouvernance vs contrôle vs rapidité. Comprendre laquelle correspond à votre contexte vous évite des mois d'errance.

II. Les trois plateformes IA décryptées

Dust : la plateforme de connaissance sécurisée

Thèse produit : Dust transforme les entreprises en système d'exploitation IA unifié, connectant données internes et outils externes via des agents gouvernés. L'hypothèse fondatrice : la valeur ne vient pas du modèle de langage lui-même mais de sa capacité à exploiter intelligemment la connaissance propriétaire de l'organisation.

Ce qui a changé récemment

Dust a franchi plusieurs caps de maturité au cours de l'année 2025. En juin 2024, la société a levé 16 millions de dollars supplémentaires auprès de Sequoia. En juillet 2025, Dust atteint 6 millions de dollars de revenu annuel récurrent (ARR), multipliant par six son chiffre d'affaires en un an. Plus révélateur encore : le taux d'utilisation hebdomadaire atteint 70% des utilisateurs actifs mensuels, un niveau comparable à Slack. Cette métrique indique que Dust n'est pas un gadget testé puis abandonné mais un outil qui s'intègre aux workflows quotidiens.

Le pricing reste stable : 29€ par utilisateur et par mois pour le plan Pro, avec une offre Enterprise sur devis pour les structures de plus de 100 personnes. Les 15 premiers jours sont gratuits. Le plan Pro inclut les coûts d'API et d'utilisation des modèles dans une logique d'usage équitable, ce qui élimine les mauvaises surprises de facturation.

Côté fonctionnalités, Dust maintient son positionnement agnostique avec un support étendu des modèles les plus récents : GPT-5 (ajouté en août 2025), Claude 4.5 Sonnet (octobre 2025), Gemini 2.5 Pro (avril 2025) et DeepSeek R1. La plateforme supporte également les modèles de raisonnement avancé comme o3 et o4-mini. La plateforme a obtenu la certification SOC 2 Type II en février 2025 et est désormais HIPAA compliant, franchissant des seuils critiques pour les ventes en entreprise, notamment dans les secteurs réglementés comme la santé. Le support du Model Context Protocol (MCP) existe depuis 2024, positionnant Dust sur les standards émergents d'interopérabilité.

Les forces identifiées

La gouvernance native constitue le différenciateur majeur de Dust. Le système de permissions fonctionne par espaces (Spaces) avec un contrôle granulaire sur qui peut accéder à quelles données et via quels agents. Cette séparation entre l'accès aux données et l'utilisation des agents évite le piège classique : déployer une IA puissante qui expose des informations sensibles à des utilisateurs non autorisés.

L'architecture "enterprise-ready" ne se limite pas à des certifications. Dust propose la connexion unique SSO (un seul identifiant pour accéder à tous vos outils) et la gestion automatisée des comptes SCIM (ajout/retrait d'utilisateurs synchronisé avec votre annuaire), des journaux d'audit complets pour tracer qui a fait quoi et quand, et une option "zéro rétention" garantissant qu'aucune donnée ne reste stockée après traitement. Le choix de l'hébergement géographique (Europe ou États-Unis) répond aux exigences de souveraineté des données. Ces fonctionnalités existent dès le plan Pro à 29€/mois, pas uniquement sur l'offre Enterprise.

La rapidité de déploiement impressionne. Dust fournit des templates préconfigurés pour les cas d'usage courants (support client, ventes, ops internes). Un agent peut être créé en quelques minutes via une interface conversationnelle qui ne requiert aucune compétence technique. L'onboarding guidé réduit le time-to-value à quelques jours plutôt qu'à plusieurs semaines.

L'infrastructure intelligente contextuelle s'appuie sur un RAG (Retrieval-Augmented Generation) conçu pour l'entreprise. Dust se connecte nativement à Slack, Notion, Google Drive, GitHub, Salesforce, Zendesk et d'autres sources via des connecteurs managés. Le système synchronise automatiquement les données et maintient les index à jour sans intervention manuelle. Cette approche évite les problèmes de données obsolètes qui plombent de nombreux projets RAG.

Les limites constatées

L'absence d'auto-hébergement crée une dépendance totale au cloud de Dust. Pour les organisations avec des exigences de déploiement sur leur infrastructure interne ou des contraintes réglementaires spécifiques, cette limitation est rédhibitoire. Dust ne propose aucune option d'installation dans votre propre infrastructure.

Le coût de scaling pose question avec l'augmentation du nombre d'utilisateurs. À 29€ par utilisateur et par mois, une équipe de 100 personnes paie 2 900€ mensuels soit 34 800€ annuels. Pour des structures où seule une partie des collaborateurs utilise intensivement les agents IA, ce modèle de pricing peut devenir prohibitif comparé à n8n en self-hosting.

Les capacités de debugging restent basiques. Dust affiche les traces de conversations et des analytics d'usage mais ne propose pas d'outils avancés de débogage granulaire comme l'inspection détaillée des appels d'API, le rejeu de séquences ou les tests unitaires d'agents. Pour des workflows complexes nécessitant un tuning fin, cette limitation ralentit l'optimisation.

L'orchestration multi-agents, bien que fonctionnelle, demeure moins sophistiquée que sur n8n. Dust gère des workflows séquentiels et des handoffs entre agents mais ne rivalise pas avec la flexibilité de routage conditionnel, de boucles complexes et de gestion d'erreurs avancée que permet une plateforme pensée d'abord pour l'automatisation.

Pour qui Dust fonctionne le mieux

Un solopreneur avec un budget de 29€ mensuels trouve dans Dust une solution clé en main si l'interface simple et le déploiement rapide compensent le coût. Pour une start-up de 6 personnes, Dust devient une option de choix : la collaboration native, les permissions par équipe et la préparation pour la compliance future justifient l'investissement de 174€ mensuels. Une PME de 70 personnes peut facilement reconnaitre dans Dust sa solution de référence : les features entreprise sont présentes dès le départ, le support MCP anticipe l'interopérabilité future et la gouvernance transversale avec permissions cross-équipes évite l'anarchie des outils.

n8n : le moteur pour équipes techniques

Thèse produit : n8n démocratise l'automatisation avancée via une approche visual-first tout en préservant la puissance technique du code. L'intuition : les workflows visuels accélèrent le développement mais le vrai contrôle vient de la possibilité d'injecter du code quand nécessaire et de maîtriser totalement l'infrastructure de déploiement.

Ce qui a changé récemment

Août 2025 a marqué un tournant tarifaire majeur pour n8n. La limitation du nombre de workflows actifs qui bridait les plans Cloud a disparu. Un nouveau plan Business ciblant les déploiements self-hosted avec features entreprise a été introduit. Le plan Enterprise adopte désormais un pricing par exécutions plutôt que par workflows, alignant mieux le coût sur l'usage réel.

Sur le Cloud, le plan Starter démarre à 24€ par mois pour 2500 exécutions. Le plan Pro passe à 60€ mensuels pour 10 000 exécutions. La Community Edition en self-hosting reste entièrement gratuite et illimitée, préservant l'ADN open source de n8n.

Pour le self-hosting, les coûts d'infrastructure varient considérablement selon l'usage. Un VPS basique coûte 5 à 10€ par mois pour tester et expérimenter. Une infrastructure de production robuste avec redondance et monitoring atteint 300 à 500€ mensuels. Cette fourchette large reflète la flexibilité mais aussi la responsabilité : vous gérez vous-même le scaling et la disponibilité.

Le projet compte 148 000 étoiles sur GitHub, le plaçant parmi les 50 projets les plus populaires de la plateforme. La communauté dépasse 200 000 membres. Cette taille critique garantit qu'un problème rencontré a probablement déjà été résolu et documenté par quelqu'un d'autre.

Les forces identifiées

La flexibilité maximale définit n8n. Avec plus de 420 connecteurs natifs, la plateforme s'intègre à l'essentiel de l'écosystème SaaS professionnel. Le nœud "Code" permet d'injecter du JavaScript ou du Python pour des traitements custom. La création de nœuds personnalisés étend les capacités au-delà des limites initiales. Le support de 20+ fournisseurs d'IA (OpenAI, Anthropic, Mistral, Ollama local, OpenRouter) évite tout verrouillage.

L'économie du modèle self-hosted change la donne pour les projets à fort volume. Une entreprise qui exécute 100 000 exécutions mensuels paie potentiellement des milliers d'euros sur une solution Cloud traditionnelle. Avec n8n self-hosted, le coût se limite à l'infrastructure serveur, qui croît linéairement et reste maîtrisable. Cette différence justifie à elle seule l'investissement dans les compétences de déploiement.

La puissance technique pour le debugging surpasse les alternatives. n8n affiche les logs détaillés de chaque exécution, permet le test individuel de chaque nœud, propose des métriques d'exécution (durée, succès, erreurs) et facilite le rejeu de workflows pour diagnostiquer les problèmes. Cette granularité accélère significativement la résolution d'incidents en production.

La communauté produit un écosystème vivant. Plus de 4 000 templates de workflows sont disponibles en partage, couvrant des cas d'usage allant de la simple synchronisation de données à des orchestrations complexes d'agents IA. Les forums réagissent vite, la documentation s'enrichit régulièrement et des contributeurs externes améliorent constamment les nœuds existants.

L'évolutivité architecturale permet de partir simple et de sophistiquer progressivement. Un projet démarre avec quelques automatisations basiques. Au fur et à mesure, il intègre des agents IA, connecte des bases vectorielles pour du RAG, orchestre des workflows multi-étapes avec gestion d'erreurs avancée. Cette trajectoire de montée en compétence est naturelle sur n8n.

Les limites constatées

La complexité initiale freine l'adoption par des profils non techniques. Comprendre la logique des nœuds, des connexions, des credentials et du flux de données demande un investissement en formation. Les messages d'erreur, bien qu'améliorés, restent parfois cryptiques pour un débutant. Sans accompagnement ou sans curiosité technique, la courbe d'apprentissage décourage.

L'UI pour créer des agents conversationnels reste rudimentaire comparée à AgentKit ou Dust. n8n excelle pour l'automatisation backend mais construire une interface de chat soignée pour exposer un agent à des utilisateurs finaux requiert du développement supplémentaire. Les templates de chatbots existent mais demandent personnalisation (messages, ton, logique) et peaufinage visuel pour obtenir une interface digne d'être exposée à vos utilisateurs

Les features de gouvernance d'entreprise sur les plans standards sont basiques. Le contrôle d'accès basé sur les rôles (RBAC) arrive sur les plans payants mais reste moins granulaire que sur Dust. L'audit logging, la gestion centralisée des credentials et les politiques de conformité nécessitent souvent des solutions externes ou du travail d'intégration.

La performance en single-process par défaut limite le scaling vertical. Pour des workflows gourmands en ressources ou des volumes élevés, passer en mode queue (avec Redis ou Postgres) devient nécessaire. Cette migration, bien documentée, représente néanmoins une étape technique supplémentaire et une couche de complexité opérationnelle.

Pour qui n8n fonctionne le mieux

Un solopreneur avec des compétences techniques trouve dans n8n self-hosted un rapport qualité-prix imbattable. Le coût se limite au serveur (moins de 10€ par mois pour commencer) et la flexibilité est totale. Une start-up de 6 personnes avec au moins un profil technique bénéficie d'une solution économique qui scale avec la croissance. Pour une PME de 70 personnes disposant d'une équipe IT, n8n avec le plan Business offre le contrôle maximal sur l'infrastructure, les données et les coûts, tout en apportant des fonctionnalités de gestion adaptées à l'échelle.

AgentKit : le toolkit OpenAI

Thèse produit : AgentKit simplifie radicalement la création d'agents OpenAI via une approche visual-first mais sacrifie la flexibilité et l'indépendance pour y parvenir. Le calcul : la friction du développement disparaît si vous acceptez de construire entièrement dans l'écosystème OpenAI.

Ce qui a changé récemment

AgentKit a été dévoilé le 6 octobre 2025 lors du DevDay d'OpenAI. Cette jeunesse explique beaucoup de ses forces et de ses faiblesses. Le lancement s'est fait avec trois composants principaux et un quatrième en cours de déploiement.

Agent Builder, le canvas visuel pour composer des workflows d'agents, est disponible en beta pour les clients API, Enterprise et Edu. ChatKit, le toolkit pour embarquer des interfaces de chat, est en disponibilité générale. Les nouvelles capacités d'évaluation (Evals : tests automatisés pour mesurer la performance des agents) permettant d'utiliser des jeux de données de référence, d'analyser pas à pas les exécutions et d'optimiser les prompts sont également en disponibilité générale (GA). Le Référentiel des connecteurs, qui centralise la gestion des sources de données et des outils, commence un déploiement beta limité, nécessitant la console d'administration globale.

Le pricing suit le modèle usage-based classique d'OpenAI : vous payez les tokens des modèles utilisés, les appels aux outils (Code Interpreter à 0,03$ par session, File Search à 0,10$ par GB-jour) et le stockage. La facturation pour le stockage ChatKit débute le 1er novembre 2025. Avant cette date, aucun frais ne s'applique sur le storage. ChatKit inclut 1 GB gratuit par mois, puis 0,10$ par GB-jour.

Agent Builder lui-même est gratuit en phase de design. Vous ne payez que lorsque vous lancez les exécutions (Run), au tarif standard des APIs. Cette approche permet de prototyper sans coût puis de mesurer l'usage réel avant d'engager un budget significatif.

Les forces identifiées

La simplicité d'onboarding est radicale. Agent Builder propose une interface drag-and-drop où vous assemblez des nœuds (prompts, outils, guardrails) en quelques clics. Pas de configuration serveur, pas de gestion d'environnement, pas de credentials multiples. Vous partez d'un canvas vide ou d'un template et vous construisez un agent fonctionnel en moins d'une heure.

L'intégration native à l'écosystème OpenAI apporte des avantages concrets. L'accès aux derniers modèles (GPT-5, modèles de raisonnement O-series) se fait sans délai. Les outils d'évaluation (Evals) permettent de mesurer la performance des agents avec des datasets, des graders automatiques et de l'optimisation de prompts. Cette suite d'outils, bien qu'encore jeune, bénéficie de l'expertise d'OpenAI en matière de LLMs.

L'expérience utilisateur via ChatKit atteint un niveau de finition design rare. L'interface propose 21 widgets interactifs, le streaming de réponses, la gestion de threads, le support d'uploads et un rendu soigné. Vous pouvez l'héberger chez OpenAI pour démarrer vite ou l'auto-héberger si vous avez besoin de contrôle additionnel. Dans les deux cas, l'intégration est fluide.

Les fonctionnalités innovantes comme les Guardrails (garde-fou en français : ce sont les protections contre les fuites de données personnelles et les attaques de contournement du modèle) et le contrôle global du déroulement des workflows positionnent AgentKit sur la frontière de l’innovation. Ces capacités, en beta ou récemment sorties, montrent qu'OpenAI investit massivement dans l'outillage développeur.

Les limites constatées

Le verrouillage OpenAI est total et assumé. AgentKit ne fonctionne qu'avec les modèles OpenAI. Aucune possibilité d'utiliser Claude, Gemini, Mistral ou des modèles open source comme Llama. Cette dépendance crée un risque stratégique : si OpenAI change ses tarifs, modifie ses CGU ou connaît des problèmes de disponibilité, vous n'avez aucun plan B.

L'orchestration reste rigide. Le routing entre agents suit une logique séquentielle avec des conditions if/else manuelles. Pas d'autonomie décisionnelle avancée, pas de boucles complexes, pas de gestion d'erreurs sophistiquée. Pour des workflows simples, cela suffit. Pour des processus métiers complexes, les limites apparaissent vite.

L'immaturité du produit se mesure objectivement. Lancé en octobre 2025, AgentKit n'a aucun track record de production, aucun retour d'expérience sur des déploiements à grande échelle, aucune garantie de stabilité des APIs ou des interfaces. Les early adopters assument le rôle de beta testeurs.

Les limitations pour le scaling en entreprise sont multiples. Pas de features de gouvernance avancée (SSO, SCIM, audit trails détaillés, RBAC granulaire). L'export de workflows vers d'autres plateformes est désactivé quand le MCP est utilisé, créant un enfermement additionnel. Les capacités RAG natives se limitent à l'upload manuel de fichiers sans synchronisation continue avec vos sources de données internes.

La prévisibilité des coûts est faible. Le modèle usage-based signifie que vous ne savez pas à l'avance combien coûtera une requête complexe. Un agent qui lance une chaîne d'actions imprévue peut exploser votre budget. Le monitoring des coûts en temps réel devient critique mais requiert une discipline opérationnelle que toutes les équipes n'ont pas.

Pour qui AgentKit fonctionne le mieux

Un solopreneur qui veut prototyper rapidement un chatbot conversationnel trouve dans AgentKit l'outil idéal pour démarrer. La simplicité compense le risque de lock-in à ce stade. Une start-up de 6 personnes peut utiliser AgentKit pour des prototypes et des démonstrations, mais l'amener en production devient risqué sans plan de migration. Une PME de 70 personnes devrait éviter AgentKit en l'état : le manque de gouvernance, l'absence de track record et les coûts imprévisibles rendent le choix inadapté aux exigences d'une structure établie.

Le cas d'usage optimal pour AgentKit se limite actuellement aux chatbots intégrés au produit (exposés aux utilisateurs finaux) pour des startups construites à 100% sur OpenAI qui acceptent le compromis entre rapidité de développement et flexibilité long terme. Pour tout autre scénario, les alternatives offrent un meilleur rapport bénéfice-risque

III. Le benchmark factuel

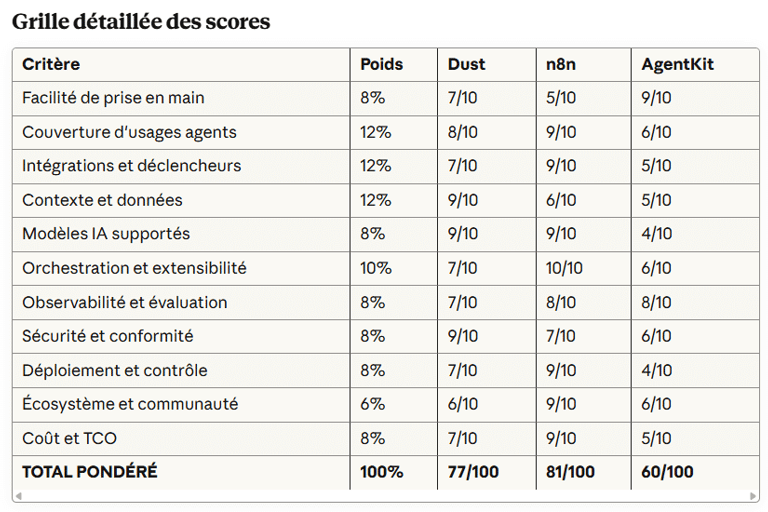

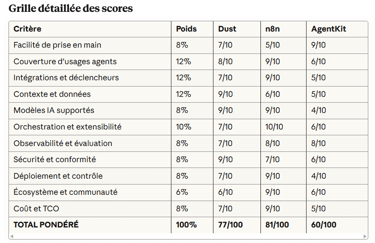

Méthodologie de scoring

Ce benchmark repose sur 11 critères pondérés qui reflètent les priorités réelles d'un déploiement d'agents IA en production. Les poids ont été calibrés sur la base de centaines de retours d'expérience d'entreprises ayant échoué ou réussi leur adoption. Les critères opérationnels (intégrations, contexte, orchestration) pèsent plus lourd que les critères de confort (facilité d'usage, écosystème).

Les scores individuels (de 0 à 10) combinent des éléments factuels vérifiables (nombre de connecteurs, certifications de sécurité, pricing public) et des évaluations qualitatives fondées sur des tests pratiques et des retours utilisateurs documentés. Cette approche hybride évite deux pièges : le benchmark purement marketing qui ignore les réalités du terrain et l'analyse purement subjective qui manque d'ancrage mesurable.

Les scores ont été challengés et ajustés en octobre 2025 pour refléter les évolutions récentes : le nouveau pricing de n8n, la maturité accrue de Dust avec sa certification SOC2 et son ARR dépassant le million de dollars, et l'arrivée toute fraîche d'AgentKit avec son manque de track record.

Analyse par catégorie

Facilité de prise en main : AgentKit domine avec 9/10 grâce à son interface drag-and-drop qui ne requiert aucune compétence technique. Vous pouvez créer un premier agent en 30 minutes sans lire de documentation. Dust obtient 7/10 avec une interface conversationnelle accessible mais qui demande tout de même de comprendre les concepts d'agents, de data sources et de permissions. n8n récupère 5/10 : l'approche visuelle aide mais la logique des nœuds, des credentials et des flux de données nécessite un temps d'apprentissage significatif pour les profils non techniques.

Couverture d'usages agents : n8n mène avec 9/10 car il couvre aussi bien les workflows d'automatisation simples que les orchestrations complexes d'agents multi-étapes avec gestion d'erreurs avancée. Dust suit à 8/10, excellant sur les agents conversationnels et les cas d'usage knowledge-intensive mais moins polyvalent sur l'automatisation pure. AgentKit stagne à 6/10, performant sur les chatbots mais limité dès qu'on sort de ce périmètre.

Intégrations et déclencheurs : n8n écrase la concurrence avec 9/10 et ses 422 connecteurs natifs couvrant l'essentiel de l'écosystème SaaS professionnel. Dust marque 7/10 avec des connecteurs managés pour les sources principales (Slack, Notion, Drive, GitHub, Salesforce, Zendesk...) mais une bibliothèque moins exhaustive. AgentKit reste à 5/10 avec le Connector Registry en beta limitée et un périmètre d'intégrations restreint aux applications OpenAI-compatibles.

Contexte et données : Dust brille avec 9/10 grâce à son infrastructure RAG de niveau entreprise, ses capacités de synchronisation automatique des sources et son système de permissions fin, compatible avec le protocole MCP. n8n obtient 6/10 : il permet le RAG via des bases vectorielles, mais cela requiert une configuration manuelle et un travail d’intégration pour relier les bases de données. AgentKit plafonne à 5/10, limité à un File Search basique et à des imports manuels de fichiers sans synchronisation continue.

Modèles IA supportés : Dust et n8n ex-aequo à 9/10. Dust supporte GPT-4/5, Claude 3.5/4.5, Gemini, Mistral dans une logique agnostique. n8n va encore plus loin avec 20+ fournisseurs incluant LangChain, Ollama local et OpenRouter. AgentKit chute à 4/10 avec un lock-in total sur les modèles OpenAI sans aucune alternative possible.

Orchestration et extensibilité : n8n atteint le maximum avec 10/10. Les workflows visuels supportent des logiques complexes (boucles, conditions, parallélisation, sous-workflows), le nœud Code permet d'injecter du custom et la création de nœuds personnalisés étend les possibilités à l'infini. Dust marque 7/10 avec des workflows multi-agents fonctionnels mais moins sophistiqués. AgentKit reste à 6/10 avec un routing séquentiel rigide et des limitations pour les orchestrations avancées.

Observabilité et évaluation : AgentKit surprend positivement avec 8/10, grâce à ses outils d’évaluation intégrés (Evals) combinant datasets, analyse pas à pas des exécutions et optimisation de prompts, qui tirent parti de l’expertise d’OpenAI. n8n obtient également 8/10, avec ses logs détaillés, ses métriques d’exécution et son debugging granulaire. Dust se limite à 7/10 : les logs et les analytics d’usage sont bien présents, mais les outils de debugging avancé restent absents.

Sécurité et conformité : Dust domine avec 9/10. La plateforme coche toutes les cases clés de la sécurité d’entreprise : certification SOC 2 Type II (audit indépendant sur la protection des données), conformité RGPD, prise en charge du standard médical HIPAA, connexion sécurisée via SSO, gestion automatisée des comptes via SCIM, absence totale de conservation des données après traitement et hébergement au choix en Europe ou aux États-Unis. n8n obtient 7/10 : le contrôle d’accès par rôles (RBAC) est disponible sur les plans payants et le self-hosting permet de garder la maîtrise complète de l’infrastructure, mais la solution ne dispose pas encore de certifications de sécurité “entreprise” officielles. AgentKit reste à 6/10 : il intègre des mécanismes de protection (guardrails) encore en version bêta et des mesures de sécurité de base mais n’offre pas de certification SOC 2, HIPAA ni de fonctions de gouvernance avancées.

Déploiement et contrôle : n8n obtient 9/10 grâce à son mode d’hébergement autonome (self-hosting), entièrement gratuit, qui permet aux entreprises de garder la main sur leurs serveurs, leurs données et leurs coûts. Dust et AgentKit, qui fonctionnent uniquement dans le cloud, obtiennent respectivement 7/10 et 4/10. Dust offre tout de même quelques garanties, comme le choix du lieu d’hébergement des données (Europe ou États-Unis) et un contrat de service clair (SLA) précisant la disponibilité garantie. AgentKit, en revanche, est hébergé exclusivement sur l’infrastructure d’OpenAI, sans option alternative, ce qui réduit fortement le contrôle que les entreprises peuvent exercer sur leurs données et leur environnement.

Écosystème et communauté : n8n cartonne à 9/10 avec 148k stars GitHub, 200k+ membres, 4 000+ templates et une communauté active qui produit constamment du contenu. Dust et AgentKit stagnent à 6/10. Dust construit une communauté d'entreprises clientes mais manque d'un écosystème de développeurs contributeurs. AgentKit, lancé il y a quelques jours, n'a pas encore eu le temps de développer une communauté significative.

Coût et TCO (coût total de possession) : n8n arrive en tête avec 9/10. Son hébergement autonome gratuit rend le coût total imbattable pour les équipes capables de gérer elles-mêmes leur infrastructure. Vous ne payez que votre serveur et vos appels aux APIs externes (modèles IA, services tiers), ce qui reste très économique à grande échelle et entièrement sous votre contrôle. Dust obtient 7/10 : son abonnement par utilisateur (29 €/mois) est simple et prévisible, mais la facture peut rapidement grimper pour les entreprises comptant des dizaines d'utilisateurs. AgentKit se limite à 5/10 : son modèle de facturation à l'usage (tokens consommés, outils appelés, volume de stockage) rend les coûts difficiles à anticiper. Sans un suivi rigoureux de la consommation, la note peut devenir élevée.

Score global et interprétation

n8n arrive en tête avec 81/100, confirmant sa position de champion de la flexibilité technique. Ce score reflète l'équilibre exceptionnel entre puissance, économie et contrôle. n8n convient à toute équipe disposant d'au moins un profil technique capable de gérer l'infrastructure et prêt à investir dans la courbe d'apprentissage.

Dust suit de près à 77/100, s'imposant comme le leader enterprise. Ce score valide la promesse d'une plateforme gouvernée, sécurisée et rapidement déployable. Dust s'adresse aux organisations qui privilégient le time-to-value et acceptent de payer pour une solution managée répondant aux exigences de conformité.

AgentKit ferme la marche à 60/100, pénalisé par son immaturité, son verrouillage OpenAI et ses limitations structurelles. Ce score ne signifie pas qu'AgentKit est inutile mais qu'il se cantonne aujourd'hui à un périmètre restreint : le prototypage rapide de chatbots pour des équipes OpenAI-native acceptant les limites et compromis imposés par l’écosystème.

L'écart de 21 points entre n8n et AgentKit illustre la différence fondamentale entre une plateforme mature pensée pour la production et un toolkit récent optimisé pour la démonstration. L'écart de 4 points seulement entre n8n et Dust montre que les deux approches (contrôle technique vs gouvernance managée) répondent à des besoins légitimes avec des niveaux de qualité comparables.

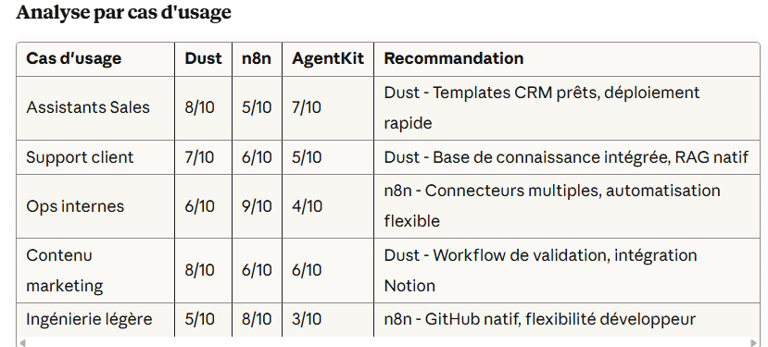

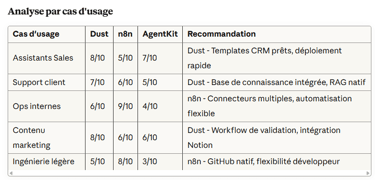

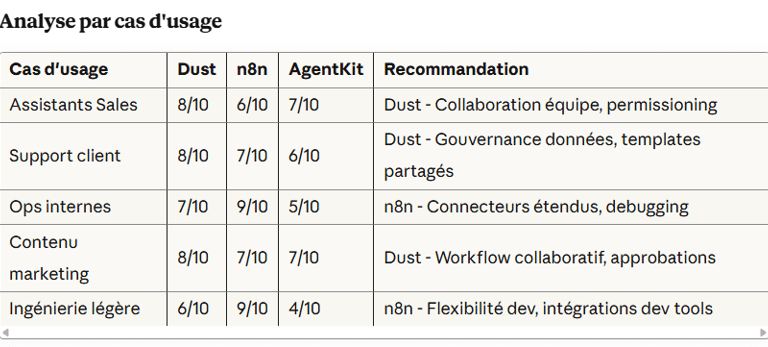

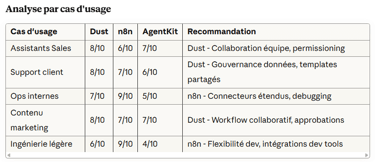

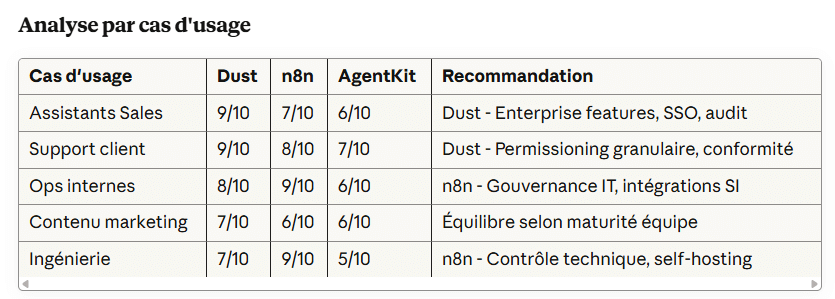

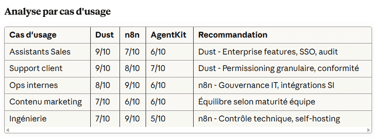

IV. Trois plateformes IA, trois choix

Le scoring global éclaire mais ne suffit pas. Votre contexte détermine quel outil vous convient. Un solopreneur technique, une start-up en hypercroissance et une PME établie n'ont ni les mêmes contraintes ni les mêmes priorités. Voici comment choisir selon votre profil.

Profil 1 : Le solopreneur (budget <100€/mois)

Contexte : Vous travaillez seul ou avec un associé. Votre budget mensuel pour les outils d'automatisation et d'IA ne peut pas dépasser 100€. Votre priorité : obtenir de la valeur rapidement sans passer des semaines en configuration. Les opérations doivent rester minimales car vous n'avez pas de temps à perdre en maintenance d'infrastructure.

Recommandation finale : n8n auto-hébergé si vous avez des compétences techniques, sinon Dust.

Justification : Si vous êtes à l'aise avec Docker, la ligne de commande et les concepts de déploiement, n8n auto-hébergé devient imbattable. Vous payez uniquement votre VPS (5 à 10€ par mois chez des providers comme Hostinger ou DigitalOcean) et vous bénéficiez d'une flexibilité totale. La Community Edition est gratuite et illimitée. Vous pouvez connecter tous vos outils, créer des workflows complexes et faire évoluer votre setup au rythme de votre activité.

Si vous n'avez pas ces compétences ou pas le temps de les acquérir, Dust à 29€ par mois offre le meilleur rapport simplicité-puissance. L'interface conversationnelle, les templates prêts et le déploiement en quelques minutes compensent le coût. Vous êtes opérationnel en une journée plutôt qu'en une semaine.

AgentKit peut séduire pour créer rapidement un chatbot de démonstration mais le modèle usage-based rend les coûts imprévisibles dès que l'usage augmente. Pour un solopreneur qui doit maîtriser ses dépenses, cette incertitude est problématique.

Profil 2 : La start-up de 6 personnes (budget 500-2000€/mois)

Contexte : Vous êtes une équipe réduite en phase de product-market fit. Vous expérimentez rapidement, pivotez souvent et connectez une dizaine d'outils SaaS différents. Vous avez probablement un ou deux profils techniques dans l'équipe mais pas encore de CTO à plein temps. Votre budget mensuel pour l'IA et l'automatisation se situe entre 500 et 2000€. Vous privilégiez la vitesse d'exécution sur la perfection technique.

Recommandation finale : Dust si vous avez besoin de collaboration immédiate et de gouvernance précoce, sinon n8n Cloud pour la flexibilité technique.

Justification : Dust, à 174 € par mois pour six utilisateurs, offre la collaboration native dont les start-ups ont besoin. Les espaces partagés, la gestion des permissions par équipe et la possibilité de créer des agents mutualisés accélèrent le déploiement et l’adoption. Sa gouvernance intégrée avec journaux d’audit et gestion fine des accès prépare dès aujourd’hui le terrain pour la conformité réglementaire que vos futurs clients en entreprise exigeront. Le support du protocole MCP anticipe, lui, l’interopérabilité avec d’autres outils à mesure que votre environnement technologique se complexifie.

n8n Cloud au plan Pro (60€ par mois pour 10 000 exécutions) convient si vous avez un profil technique dans l'équipe et que vos workflows tirent parti des 422 connecteurs. Vous bénéficiez de la flexibilité de n8n sans gérer l'infrastructure vous-mêmes. Cette option fonctionne bien pour les start-ups tech-centric où l'automatisation backend complexe crée un avantage compétitif.

La nuance critique sur AgentKit : AgentKit n’a de véritable intérêt que si votre cas d’usage principal consiste à intégrer un chatbot conversationnel directement dans votre produit. Si vous développez une application SaaS où l’IA conversationnelle constitue une fonctionnalité centrale et que vous évoluez déjà dans l’écosystème OpenAI, la plateforme permet de réduire significativement le délai de mise sur le marché. En revanche, pour tous les autres scénarios type automatisation en back-end, workflows multi-systèmes ou agents de traitement de données, AgentKit atteint vite ses limites et vous contraindra tôt ou tard à migrer vers Dust ou n8n, au risque de perdre plusieurs semaines de développement.

Profil 3 : La PME de 70 personnes (budget 5-15k€/mois)

Contexte : Vous êtes une organisation établie avec des processus structurés, plusieurs départements et des exigences strictes en matière de sécurité et de conformité. Vous avez probablement déjà subi un audit de sécurité ou préparez une certification. Votre direction financière demande des garanties sur la protection des données et la traçabilité. Votre équipe IT veut garder le contrôle sur ce qui touche aux systèmes d'information. Votre budget mensuel pour l'IA peut atteindre 5 à 15k€ si le ROI est démontré.

Recommandation finale : Dust pour la majorité des déploiements transversaux, avec n8n en complément pour les besoins IT spécifiques.

Justification : Dust, à 2 030 € par mois pour 70 utilisateurs (plan Pro) ou en plan Enterprise sur devis, intègre les fonctionnalités clés attendues par les PME : certification SOC 2 Type II, authentification unifiée (SSO) avec gestion automatique des comptes via SCIM, journaux d’audit complets, gestion fine des permissions entre équipes et support du protocole MCP pour garantir l’interopérabilité future. Ces fonctions ne relèvent pas du confort mais constituent de véritables prérequis pour réussir les audits de sécurité de vos clients et assurer la conformité au RGPD.

La gouvernance transversale que Dust offre résout un problème récurrent dans les PME : chaque département expérimente ses propres outils IA sans coordination, créant du shadow IT et des risques de sécurité. Dust centralise la gestion tout en permettant à chaque équipe de créer ses agents spécifiques avec les permissions appropriées.

Le cas d'usage hybride Dust + n8n : Certaines PME déploient Dust pour les agents conversationnels orientés knowledge (support, sales, RH) et n8n en auto-hébergement pour l'automatisation backend complexe pilotée par l'IT (intégrations ERP, workflows de données, monitoring système). Cette approche combinée exploite les forces de chaque plateforme : Dust pour l'accessibilité métier et la gouvernance, n8n pour la puissance technique et le contrôle infrastructure.

AgentKit reste inadapté à l'échelle PME en l'état. Le manque de features enterprise (pas de SSO natif, gouvernance limitée, pas de certifications), l'absence de track record en production et les coûts imprévisibles en font un choix risqué pour une organisation qui doit rendre des comptes sur ses investissements technologiques.

V. Dix signaux pour affiner votre choix

Les recommandations par profil donnent une direction. Mais votre situation contient des spécificités que seuls des signaux précis permettent d'évaluer. Voici dix indicateurs qui clarifient quel outil correspond vraiment à votre contexte.

Choisir Dust si...

✅ La gouvernance et la conformité sont non négociables

Vous travaillez dans un secteur réglementé (finance, santé, juridique...) ou vos clients exigent des garanties de sécurité documentées. Vous avez besoin de SOC2, de support HIPAA ou de résidence de données EU. Dust est le seul des trois à cocher toutes ces cases dès le plan Pro.

✅ Vos équipes métier doivent créer des agents sans dépendre de l'IT

Vous voulez que vos responsables commerciaux, vos managers support ou vos chefs de projet construisent leurs propres assistants IA sans tickets à l'IT. L'interface conversationnelle de Dust et les templates préconfigurés rendent cette autonomie réaliste.

✅ Votre budget privilégie la prévisibilité sur l'optimisation

Vous acceptez de payer 29€ par utilisateur et par mois pour éliminer les surprises de facturation et les heures passées à optimiser les coûts. Le modèle de pricing de Dust est le plus simple et le plus stable des trois.

✅ Le déploiement rapide prime sur la flexibilité architecturale

Vous devez montrer de la valeur en quelques semaines plutôt qu'en quelques mois. Les jours passés à configurer une infrastructure n'apportent pas de ROI immédiat. Dust vous met en production en quelques jours.

✅ Le RAG enterprise-grade est au cœur de votre usage

Vos agents doivent exploiter des documents internes, des bases de connaissances ou des sources de données multiples avec des permissions granulaires. L'infrastructure RAG de Dust, pensée pour l'entreprise dès l'origine, surpasse ce que n8n ou AgentKit proposent en standard.

Choisir n8n si...

✅ Vous avez au moins un profil technique dans l'équipe

Quelqu'un maîtrise Docker, comprend les APIs et sait déboguer un workflow qui échoue. Sans cette compétence, n8n devient frustrant. Avec elle, n8n devient extraordinairement puissant.

✅ Vos workflows dépassent 5 étapes avec des logiques conditionnelles complexes

Vous orchestrez des processus métiers qui incluent des boucles, des parallélisations, des conditions if/then/else imbriquées et des gestions d'erreurs sophistiquées. n8n excelle là où Dust et AgentKit montrent leurs limites.

✅ Le contrôle du budget est critique

Vous connaissez votre volume d'exécutions mensuelles et vous voulez un coût fixe prévisible (ou nul en self-hosting). Le modèle économique de n8n, fondé sur les exécutions plutôt que sur les utilisateurs ou les tokens, correspond à cette contrainte.

✅ Vous intégrez plus de 10 systèmes différents

Votre environnement technologique est hétérogène : un CRM sur mesure, un ERP ancien, des API internes, plusieurs bases de données et une dizaine d’applications SaaS. Les nombreux connecteurs natifs de n8n permettent de couvrir ce périmètre sans effort particulier, là où Dust et AgentKit exigeraient un développement spécifique pour chaque intégration.

✅ Vous voulez garder le contrôle de l'infrastructure et des données

L'auto-hébergement est un prérequis pour vous, que ce soit pour des raisons de souveraineté, de conformité spécifique ou de contrôle opérationnel. n8n est le seul des trois à offrir cette option.

Choisir AgentKit si...

✅ Votre stratégie IA est 100% OpenAI et vous l'assumez

Vous avez déjà standardisé sur les modèles OpenAI, votre équipe connaît leurs APIs et vous acceptez le verrouillage en échange de l'intégration profonde. AgentKit devient alors cohérent.

✅ Vous devez prototyper un chatbot en quelques heures

Vous avez une démo client dans 48 heures, un pitch investisseurs la semaine prochaine ou un POC à livrer vendredi. AgentKit permet de construire un agent conversationnel fonctionnel plus vite que n'importe quelle alternative.

✅ Votre cas d'usage se limite à moins de 3 agents avec un routing simple

Vous ne construisez pas un système d'orchestration complexe mais une ou deux interactions conversationnelles basiques. Les limitations d'AgentKit ne vous affectent pas à cette échelle.

✅ Vous êtes en mode early adopter et tolérez l'immaturité

Vous acceptez d'être beta testeur, vous documentez les bugs que vous rencontrez et vous avez un plan B si AgentKit ne tient pas ses promesses. Cette posture d'expérimentation est consciente et assumée.

✅ Vous développez un chatbot intégré à votre produit et rien d’autre

Votre application SaaS intègre un assistant conversationnel comme feature central et vous utilisez ChatKit pour l'interface utilisateur. C'est le use case optimal d'AgentKit et celui où il apporte le plus de valeur différenciée.

Éviter AgentKit si...

❌ Vos workflows dépassent 10 étapes

Dès que les workflows dépassent quelques étapes séquentielles, son routage rigide et l’absence de mécanismes avancés de gestion des erreurs deviennent rapidement des freins majeurs

❌ Vous avez besoin d'une stratégie multi-cloud

Le lock-in OpenAI signifie que vous dépendez d'un seul fournisseur pour vos modèles, votre infrastructure d'agents et vos outils d'évaluation. Cette concentration de risque est incompatible avec une approche multi-cloud.

❌ Vous prévoyez de dépasser 50 utilisateurs à moyen terme

AgentKit manque de fonctions de gouvernance adaptées aux déploiements à grande échelle : pas de connexion unifiée (SSO) intégrée, pas de gestion fine des rôles et des accès (RBAC), pas de journaux d’audit détaillés, ni de suivi centralisé des coûts par équipe.

❌ L'auto-hébergement est un prérequis

OpenAI ne propose aucune option d’installation locale (on-premise) pour AgentKit. Si vos exigences réglementaires ou de souveraineté imposent un hébergement au sein de votre propre infrastructure, AgentKit est automatiquement exclu du périmètre des solutions possibles.

❌ Votre secteur impose une conformité stricte.

L’absence de certifications de sécurité reconnues (SOC 2, HIPAA), le manque de mécanismes de conformité avancés et l’immaturité du produit rendent AgentKit inadapté aux environnements fortement réglementés.

VI. Checklist de décision

Avant de démarrer un projet d'agents IA, répondez à ces trois questions critiques. Elles déterminent 80% du choix de plateforme.

Question 1 : Avez-vous des compétences techniques internes disponibles ?

Si OUI : n8n devient viable et potentiellement optimal. Vous exploiterez sa flexibilité maximale et son économie.

Si NON : Orientez-vous vers Dust ou AgentKit. Ces plateformes abstraient la complexité technique au prix d'une moindre flexibilité.

Question 2 : Quel est votre budget sur 12 mois ?

< 500€ : n8n auto-hébergé (si compétences) ou commencez avec AgentKit (si prototypage pur)

500-3000€ : Dust pour 1-10 users ou n8n Cloud selon profil technique

3000-15 000€ : Dust plan Pro pour 10-50 users avec collaboration

> 15 000€ : Dust Enterprise ou n8n Business avec support dédié

Question 3 : Quelle est votre priorité : vitesse, contrôle ou gouvernance ?

Vitesse : AgentKit pour des prototypes jetables, Dust pour de la production rapide

Contrôle : n8n self-hosted sans hésitation

Gouvernance : Dust est conçu pour cela dès l'origine

Checklist Dust

Avant de choisir Dust, validez ces points :

☐ Votre budget supporte 29€/user/mois sur 12 mois minimum

☐ Vos cas d'usage prioritaires sont orientés connaissance (knowledge-intensive) et nécessitent du RAG

☐ Vos sources de données sont compatibles avec les connecteurs Dust (Slack, Notion, Drive, GitHub, Salesforce, Zendesk, etc.)

☐ Votre équipe privilégie l'accessibilité et la collaboration sur la flexibilité technique maximale

☐ Le Cloud-only ne pose pas de problème de conformité ou de souveraineté pour votre organisation

Checklist n8n

Avant de choisir n8n, validez ces points :

☐ Au moins une personne dans l'équipe maîtrise Docker, les APIs et le debugging technique ou vous avez un budget formation et une personne technique motivée

☐ Votre infrastructure d'auto-hébergement est prête (serveurs, monitoring, sauvegardes) ou vous acceptez le Cloud avec un budget validé

☐ Vos workflows comptent plus de 5 étapes ou requièrent une orchestration complexe qui justifie la puissance de n8n

☐ Vous intégrez plus de 10 systèmes différents et les connecteurs natifs de n8n couvrent vos besoins

☐ Vous avez identifié qui sera responsable de la maintenance et des mises à jour de la plateforme

Checklist AgentKit

Avant de choisir AgentKit, validez ces points :

☐ Votre stratégie IA est basée à 100% sur OpenAI et vous acceptez ce verrouillage à long terme

☐ Vos cas d'usage se limitent à des agents conversationnels simples (moins de 3 agents, routing basique)

☐ Votre budget accepte un modèle usage-based avec une variabilité importante des coûts mensuels

☐ Votre équipe tolère l'immaturité du produit (lancé en octobre 2025) et accepte le rôle d'early adopter

☐ Vous avez un plan B si AgentKit ne tient pas ses promesses ou si OpenAI change ses conditions

VII. Ce qu'on ne vous dit pas

Les présentations marketing des plateformes d'agents IA mettent en avant les succès et occultent les difficultés réelles. Voici les pièges que vous découvrirez de toute façon, autant les anticiper.

Piège 1 : Sous-estimer la préparation des données

70 % du temps d’un projet RAG réussi est consacré à préparer et structurer les données sources.

Une entreprise industrielle française a par exemple voulu créer un assistant pour ses équipes techniques à partir de ses manuels internes et rapports de maintenance. Avant toute exploitation, il a fallu recenser plusieurs centaines de documents, supprimer les doublons, ajouter des étiquettes de contexte (type d’équipement, date de mise à jour, site concerné) et découper les PDF en sections logiques. Ce travail préparatoire, souvent sous-estimé, a représenté plus de la moitié du temps total du projet, mais a permis d’obtenir des résultats fiables dès le premier déploiement.

Si vous négligez cette étape, votre agent produira des réponses incohérentes ou obsolètes. La technologie RAG ne compense pas des données de mauvaise qualité. Elle les amplifie.

L'action corrective : Allouez 40 à 60% du budget temps de votre projet à l'audit et à la préparation des données. Créez un inventaire des sources, évaluez leur qualité (à jour ? structurées ? complètes ?) et nettoyez avant d'indexer.

Piège 2 : Négliger le change management

La technologie représente 30% du succès d'un projet d'agents IA. Les 70% restants sont humains : formation, accompagnement, gestion des résistances, célébration des succès. Une PME du BTP a déployé un système de génération de devis en 8 semaines. Les 4 semaines suivantes ont été consacrées à convaincre les commerciaux que l'outil ne les remplaçait pas mais les libérait des tâches administratives.

Sans ce travail de communication et de formation, les collaborateurs contournent l'outil ou l'utilisent minimalement. Votre projet techniquement réussi produit zéro valeur parce qu'il n'est pas adopté.

L'action corrective : Impliquez les futurs utilisateurs dès la phase de cadrage. Formez des ambassadeurs IA dans chaque département. Célébrez publiquement les premiers succès pour créer un effet d'entraînement.

Piège 3 : Croire au "one size fits all"

Aucune des trois plateformes ne couvre tous les cas d'usage de manière optimale. Dust excelle sur le knowledge management mais peine sur l'automatisation backend complexe. n8n domine l'orchestration mais demande des compétences techniques. AgentKit accélère le prototypage conversationnel mais enferme dans l'écosystème OpenAI.

Les entreprises qui réussissent le mieux leur adoption d'agents IA utilisent souvent deux plateformes complémentaires plutôt qu'une seule. Dust pour les agents conversationnels orientés métiers et n8n pour les workflows techniques pilotés par l'IT représente une combinaison cohérente.

L'action corrective : Cartographiez vos cas d'usage et acceptez qu'ils requièrent peut-être des outils différents. Préférez l'excellence ciblée à la médiocrité généralisée.

Piège 4 : Ignorer le TCO réel

Le pricing affiché ne reflète jamais le coût total de possession. Dust à 29€ par utilisateur exclut les coûts de formation, d'accompagnement au changement et de maintenance des sources de données. n8n auto-hébergé est gratuit en licence mais inclut les coûts du serveur, du monitoring, des sauvegardes, de la sécurité et du temps de la personne qui gère l'infrastructure. AgentKit facture les tokens et les tools mais vous devez ajouter le temps passé à optimiser les prompts pour réduire la consommation.

Une start-up qui estime son TCO Dust à 174€ par mois (6 users × 29€) découvre au bout de 6 mois que le coût réel atteint 250€ par mois en incluant les heures de l'équipe passées à maintenir les data sources à jour et à créer de nouveaux agents.

L'action corrective : Calculez le TCO sur 12 mois en incluant licences + infrastructure + temps humain + formation + accompagnement. Comparez ce coût total plutôt que le seul pricing des licences.

Piège 5 : Lancer 10 POCs simultanés

67% des POCs IA ne dépassent jamais le stade expérimental selon les études de McKinsey. La raison principale : ils ne sont pas connectés à un objectif business mesurable. Une entreprise lance simultanément des POCs sur la génération de contenu marketing, l'analyse de données clients, la qualification de leads et l'assistant support. Aucun n'a de sponsor métier clairement identifié ni de KPIs définis. Six mois plus tard, tous stagnent en beta sans adoption réelle.

Les POCs multiples sans discipline de priorisation dispersent les ressources, démobilisent les équipes et créent une impression d'échec généralisé alors que les outils fonctionnent.

L'action corrective : Utilisez le framework A-RICE présenté dans l'article sur l'entreprise AI-first pour prioriser. Lancez 1 quick win (effort minimal, impact visible) et 2 POCs maximum à plus fort potentiel. Définissez des critères d'arrêt clairs avant de démarrer. Tuez impitoyablement les projets qui ne livrent pas.

Les questions sans réponse claire

Dette technique IA : comment la mesurer ?

Nous savons identifier la dette technique traditionnelle : du code ancien, une architecture qui vieillit, des dépendances mal gérées.

En revanche, la dette technique liée à l’IA reste un concept encore mal défini. Elle se traduit par des modèles déployés dont le fonctionnement interne échappe aux équipes, des dépendances à des API externes susceptibles d’évoluer ou de disparaître, des prompts calibrés pour GPT-4 devenus inopérants avec GPT-5, et des données d’entraînement obsolètes faute de mise à jour régulière.

Des cadres méthodologiques comme MLOps commencent à répondre à ces enjeux : versionnement des modèles, détection des dérives de performance et tests de régression.

Mais l’écosystème n’a pas encore atteint le niveau de maturité et de standardisation qu’offre, dans le développement logiciel classique, le clean code.

Faut-il anticiper des cycles de refonte majeure des systèmes IA tous les 3 à 5 ans comme pour une migration technologique traditionnelle ? Ou peut-on concevoir des architectures IA intrinsèquement évolutives qui vieillissent mieux ? La réponse n'est pas encore stabilisée en 2025.

Souveraineté vs Performance : quel compromis pour l'Europe ?

Les meilleurs LLMs (GPT-5, Claude 4.5, Gemini) sont américains. Les infrastructures cloud dominantes (AWS, Azure, GCP) aussi. L'Europe peut-elle développer une alternative souveraine sans accepter 2 à 3 ans de retard en performance ?

Des initiatives européennes émergent : Mistral (France) pour les modèles de langage open source, Aleph Alpha (Allemagne) pour les solutions d’IA souveraines, ou encore OVHcloud et Scaleway pour le cloud européen.

Mais choisir ces alternatives implique encore un compromis : plus de souveraineté, au prix d’une performance potentiellement inférieure.

Pour une entreprise française, faut-il privilégier les meilleurs outils (américains) en acceptant une dépendance géopolitique ou sacrifier quelques points de performance pour garder le contrôle ? Cette question stratégique dépasse le cadre technique et touche à la vision long terme de l'organisation.

Maturité des protocoles : à quand la standardisation complète ?

Le Model Context Protocol (MCP) d'Anthropic et l'Agent2Agent Protocol (A2A) de Google visent à standardiser la communication entre agents et systèmes. Dust et n8n supportent MCP. Google Vertex AI et AWS Bedrock implémentent A2A. Mais ces protocoles restent jeunes et leur adoption n'est pas encore universelle.

Faut-il miser dès maintenant sur ces standards émergents en pariant sur leur généralisation future ? Ou attendre qu'ils se stabilisent au risque de prendre du retard ? La fenêtre d'opportunité pour les early adopters existe mais le risque de choisir le mauvais protocole (celui qui ne deviendra pas le standard) reste réel.

Conclusion : Choisir en connaissance de cause

Le marché des plateformes d'agents IA est jeune, mouvant et parfois déroutant. Mais trois archétypes se dessinent clairement en 2025.

Dust s'impose pour les organisations qui privilégient la gouvernance, la conformité et le déploiement rapide. Son infrastructure RAG pensée pour l'entreprise, ses certifications de sécurité et son interface accessible aux profils non techniques en font la solution de référence pour 70% des PME et ETI. Le coût de 29€ par utilisateur et par mois se justifie par le time-to-value court et la préparation pour la compliance future.

n8n domine pour les équipes techniques qui veulent le contrôle maximum et l'économie optimale. Sa flexibilité architecturale, ses nombreux connecteurs et son modèle open source avec self-hosting gratuit créent un avantage compétitif durable pour les organisations capables de gérer l'infrastructure. Le TCO imbattable et la puissance d'orchestration compensent largement la courbe d'apprentissage.

AgentKit séduit pour le prototypage ultra-rapide de chatbots dans l'écosystème OpenAI. Sa simplicité drag-and-drop et son intégration profonde aux derniers modèles OpenAI accélèrent la démonstration. Mais son immaturité, son verrouillage complet et ses limitations structurelles le cantonnent aujourd'hui aux POCs et aux applications conversationnelles simples.

Le choix optimal n'existe pas dans l'absolu. Il émerge de votre contexte : vos compétences internes, votre budget, vos priorités stratégiques et vos contraintes de conformité. Un solopreneur technique choisira n8n. Une start-up non technique privilégiera Dust ou AgentKit selon son cas d'usage. Une PME établie se tournera vers Dust pour la majorité de ses déploiements.

La seule erreur serait de choisir par mimétisme ("Tout le monde utilise X"), par effet de nouveauté ("AgentKit vient de sortir donc c'est le meilleur") ou sans validation du contexte ("Le benchmark dit que n8n score 81/100 donc c'est forcément notre solution").

Commencez petit avec 1 ou 2 cas d'usage clairement définis. Mesurez l'impact avec des KPIs business, pas des vanity metrics d'adoption d'outils. Itérez rapidement en tuant impitoyablement ce qui ne marche pas. Scalez progressivement ce qui prouve sa valeur.

Les agents IA ne sont pas une mode passagère. Ils redéfinissent la manière dont les organisations traitent l'information, automatisent les processus et servent leurs clients. Mais cette transformation exige de la discipline, de la méthode et des choix techniques éclairés.

Glossaire

API (Application Programming Interface) : Interface permettant à deux applications de communiquer entre elles via des requêtes standardisées.

Auto-hébergement : Installation et gestion d'un logiciel sur vos propres serveurs plutôt que dans le cloud d'un fournisseur.

Canvas : Interface visuelle de type "toile blanche" où vous assemblez des éléments par glisser-déposer.

GA (Disponibilité générale) : Statut d'un logiciel officiellement lancé et disponible pour tous les utilisateurs.

HIPAA : Standard américain de protection des données de santé obligatoire pour le secteur médical.

Lock-in : Verrouillage technologique rendant difficile ou coûteux le changement de fournisseur.

MCP (Model Context Protocol) : Protocole standardisant la communication entre agents IA et sources de données externes.

On-premise : Déploiement d'un logiciel sur l'infrastructure interne d'une entreprise plutôt que dans le cloud.

POC (Proof of Concept) : Prototype démontrant la faisabilité technique d'une solution avant déploiement complet.

RAG (Retrieval-Augmented Generation) : Technique enrichissant les réponses d'une IA en récupérant des informations dans vos documents.

RBAC (Role-Based Access Control) : Système de permissions définissant qui peut accéder à quoi selon son rôle.

Scaling : Capacité d'un système à gérer une charge croissante en ajoutant des ressources.

SCIM (System for Cross-domain Identity Management) : Protocole synchronisant automatiquement les comptes utilisateurs entre applications.

SLA (Service Level Agreement) : Contrat garantissant un niveau de service minimum, notamment en disponibilité.

SOC2 Type II : Certification attestant des contrôles rigoureux de sécurité et protection des données par audit indépendant.

SSO (Single Sign-On) : Connexion unique permettant d'accéder à plusieurs applications avec un seul identifiant.

TCO (Total Cost of Ownership) : Coût total de possession incluant licences, infrastructure, formation et maintenance.

Time-to-value : Délai nécessaire entre le démarrage d'un projet et l'obtention des premiers résultats mesurables.

Token : Unité de mesure du texte traité par un modèle IA. Environ 750 mots = 1000 tokens.

Track record : Historique vérifiable de réussites et de déploiements en conditions réelles.

VPS (Virtual Private Server) : Serveur virtuel dédié hébergé dans un datacenter, alternative économique aux serveurs physiques.

Workflow : Séquence d'étapes automatisées orchestrant des actions entre plusieurs applications ou systèmes.

Blog

Contact

contact@iannis.fr

© 2025. All rights reserved.

SUIVEZ-MOI